Ready Solutions

Vaikuttavaa analytiikkaa

Meistä

Olemme kokonaisvaltaiseen tiedonhallintaan ja analytiikkaan erikoistunut yritys

Autamme asiakkaitamme saavuttamaan analytiikan avulla vaikuttavuutta organisaationsa toiminnan johtamisessa sekä kehittämisessä. Toimimme kehityskumppanina data-alustojen kehittämisen, analytiikan, ennustamisen, tekoälyn ja dataintegraatioiden osa-alueilla.

Asiakkaamme

Palvelemme analytiikan alueella yksityisiä ja julkisia organisaatioita

Ohessa osa organisaatioista, joita autamme menestymään data-alustojen sekä edistyneen analytiikan avulla.

"Readyn toimittama talousraportointi-kokonaisuus paransi analyysin - ja tiedonjaon mahdollisuuksiamme"

Mikko Koskela, talousjohtaja

Nokian kaupunki

"Kyllä saa olla tyytyväinen, kun tätä lopputulosta katsoo niin lopussa kiitos seisoo!"

Jämsän kaupungin johtoryhmän jäsen

Jämsän kaupunki

"Ready:n kanssa työskentely on ollut mutkatonta. Odotan että kumppanimme haastaa ja kehittää myös meitä"

Tatu Tulokas, Henkilöstöjohtaja

Mehiläinen Oy

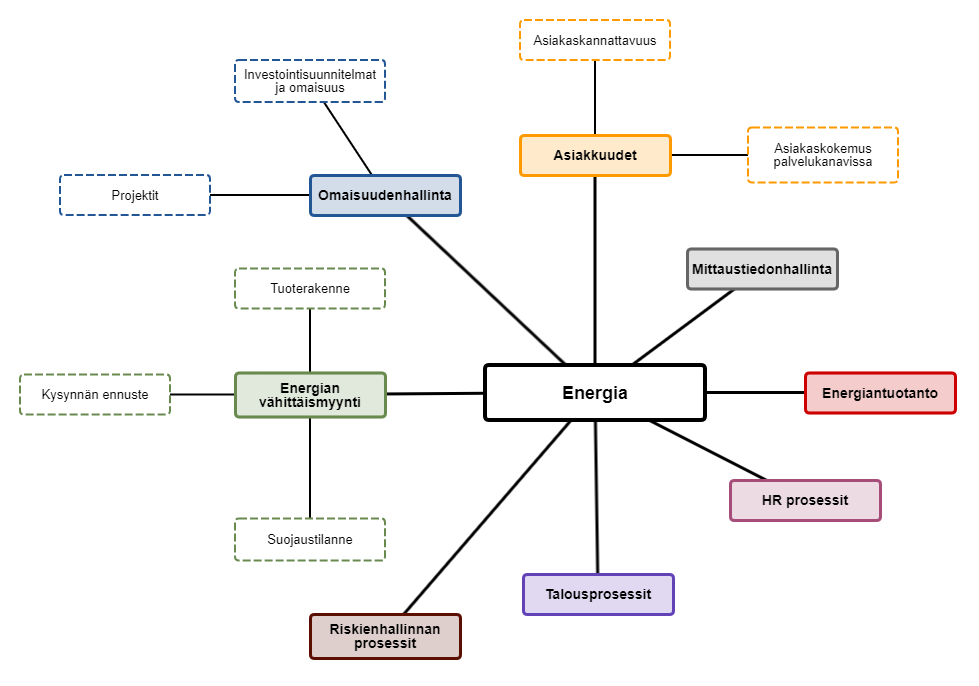

"Ready:n osaaminen sähköliiketoiminnan prosesseista, käytännöistä ja tiedoista on tukenut meitä Väreen liiketoiminnan aloittamisessa. Ready Solutions on toteuttanut ratkaisut vastuullisesti ja itsenäisesti."

Juha Keski-Karhu, Toimitusjohtaja

Väre Oy

"Pilottijakson päätteeksi konsernin luvut ovat nyt nähtävissä samalla kuin yhtiöidenkin luvut yhdellä näkymällä lähes reaaliajassa. Luvuista pääsee porautumaan tositetasolle, joka on paljastanut jonkin verran virheitä etenkin kustannuspaikkojen ja muiden seurantakohteiden kirjaamisissa"

Petteri Mussalo, CFO

Korsisaari Oy

Mitä teemme

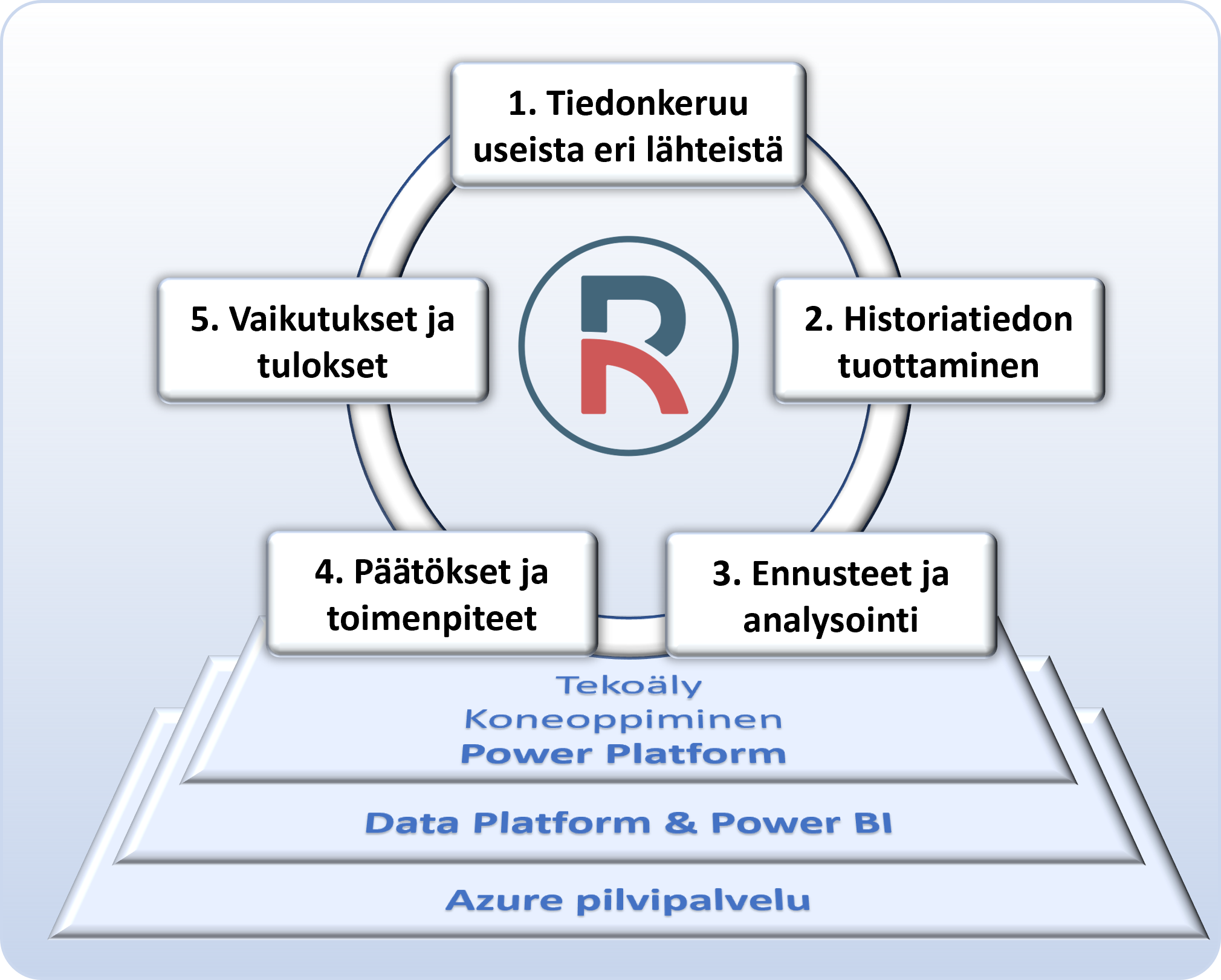

Tuotamme asiakkaan monista tietolähteistä edistynyttä analytiikkaa, jonka avulla voi tehdä toimenpiteitä ja saavuttaa vaikutuksia

Tiedon ja lähdejärjestelmien määrä kasvaa vauhdikkaasti. Autamme asiakkaitamme yhdistelemään tietoja tehokkaasti ja skaalautuvasti lukuisista eri lähteistä, muodostamaan näistä raportteja sekä edistyneen koneoppimisen avulla ennusteita. Näiden avulla pystyy suorittamaan nopeasti analyysejä ja päättämään tarvittavista toimenpiteistä. On tärkeää, että toimenpiteitä pystytään liittämään osaksi analytiikkaa, jotta voidaan analysoida niiden tuloksia ja vaikutuksia.

Näin sen teemme

Hyödynnämme data-alustojen, dataintegraatioiden sekä pilvipalveluiden kehittämisessä Microsoftin Azuren palveluita.

Hyödynnämme kokonaistoimitusprojekteissa ilmiöaluekohtaisia mallipohjia nopeuttamaan käyttöönottovaihetta. Löydät mallipohjamme Ratkaisut – valikon alta. Muissa tapauksissa tarjoamme asiakkaan omajohtoiseen kehityshankkeeseen sertifioituja kokeneita asiantuntijoitamme.