Asiantuntemuksemme

Tarjoamme osaamistamme Microsoftin Azuren teknologioista data-alustojen kehittämisestä aina pilvipalveluihin asti.

Pilvipalvelut

Data-alustan kehittäminen

Sovellukset

Edistynyt analytiikka

Ratkaisumme

Ready – ilmiöaluekohtaiset mallipohjat ovat käytännön asiakastyön kokemuksien tuloksena kehitettyjä malleja kiihdyttämään kehitystä. Ne palvelevat asiakasta suunnitteluvaiheessa sekä nopeuttavat projektitoimituksen etenemistä. Filosofiamme on, että emme asenna toimittajalukkoja, vaan asiakas omistaa aina lopputulokset täysin. Suunnitteletko toiminnan kehittämistä ja haluaisit nähdä mihin nykyaikainen pilvipalveluiden avulla rakennettu, tekoälyavusteinen data-analytiikka pystyy? Lähetä viesti myynti@readysolutions.fi osoitteeseen ja varaa palaveri haluamasi mallipohjan esittelyä varten.

Ready Industrial Analytics

Ready Business Analytics

Ready HR Analytics

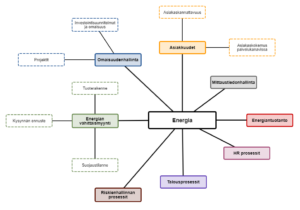

Ready Energy Analytics

Konsultointipalvelumme

Kehitämme Data & AI – ratkaisuja Microsoftin teknologioilla, kehitystarpeet ratkaistaan joko kokonaistoimitusprojektilla taikka täydentämällä asiakkaan kehitystiimiä sertifioiduilla senioritason osaajilla.